loading...

- 香港脉搏首页

- 每日专题

- 财金博客

- 理财/管理

时尚艺术慧眼识车目前“智能驾驶”都不靠谱,技术迷信从何而来?作者介绍

汽车博主,特约汽车评论员。用平静而幽默的笔触解读汽车变革。

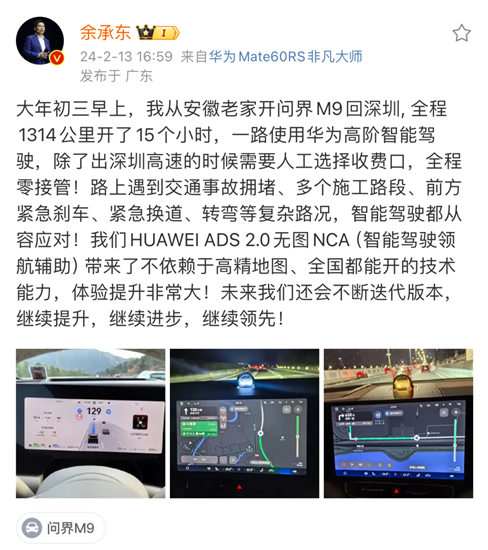

余承东春节假期在社交媒体发文,讲述自己开问界M9从安徽回深圳,一路使用华为“高阶智能驾驶”,并强调途中遇到了多种复杂路况,除高速收费口外“全程零接管”。

▲余承东在社交媒体上展示华为“高阶智能驾驶”

看到这种描述,你是不是感觉问界M9基本上能“自动驾驶”了?

这是企业在传播中常用的一种手法,刻意用“高阶智能驾驶”之类的词汇,和“全程零接管”之类的个案叙事,制造一种智能驾驶已经非常先进、甚至比人更靠谱的错觉。

模糊“智能驾驶”和“智能辅助驾驶”之间的区别,渲染“安全”、“零接管”,很可能迷惑甚至误导公众,这是非常危险和不负责任的。

智能驾驶比人强吗?

大家都应该知道的常识是:各种所谓“智能驾驶”只是“辅助驾驶”,离真正“自动驾驶”还有很长的路要走;而且,厂商自诩非常先进的“智能驾驶”,目前尚存在各种足以致命的缺陷和隐患。

特斯拉的Autopilot公认全球比较领先。马斯克在2021年声称,使用Autopilot的特斯拉发生碰撞的可能性是普通汽车的十分之一;特斯拉发布的《2022影响力报告》也显示,使用Autopilot的特斯拉,行车安全达到美国汽车平均水平的8.5倍。

但这只是特斯拉的一面之词。

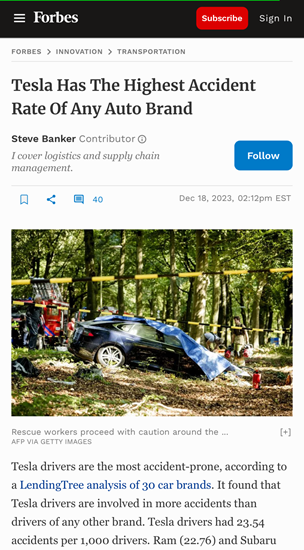

据美国多家媒体报道,在线借贷平台LendingTree去年底公布了一项研究结果,在纳入分析的30个主要汽车品牌中,特斯拉驾驶者的事故率最高。

▲据美国媒体报道,特斯拉驾驶人的事故率最高

另据《华盛顿邮报》报道,自2019年至去年中期,特斯拉的Autopilot在美国引发700多起车祸,造成17人死亡。

近两年,特斯拉汽车屡次大规模召回,以修复“有缺陷”的自动驾驶辅助系统。

在我国,特斯拉汽车突然失控、刹车失灵等引发的车祸也不时见诸媒体;蔚来、小鹏等强调“智能”的汽车品牌也被曝出一些与智能驾驶相关的车祸。

在未来,“智能驾驶”也许会比人更可靠、更安全,但至少在目前来看,风险依然很大,而且不可控,不可预测。

智能驾驶的灰区和死角

为什么总会有人轻信智能驾驶,认为比人类开车更靠谱?

这是一种新式“技术迷信”。

和人类相比,智能驾驶系统确实有一些优势。激光雷达、毫米波雷达、摄像头等传感器的感知能力很强大;在深度学习、大数据模型等人工智能技术加持下,智能驾驶系统看上去很聪明,反应比人类更快。

而且,这套系统规避了人类不少生物性缺点,它不会疲劳、不会分心、不会酒驾,也不会因为其它车辆加塞而路怒。

但智能驾驶的核心是人工智能,而人工智能技术虽然不断有新突破,却仍然面临一些“灰区”和“死角”。

美国公路交通安全管理局(NHTSA)高级安全顾问玛丽·卡明斯去年曾撰文,指出了人工智能应用在自动驾驶上的几个“危险的真相”。

首先,人会犯错,软件代码也会出错。

任何一个在软件开发领域工作过的人都深知,软件代码很容易出错,系统越复杂,问题越大。

智能驾驶是一个非常复杂的系统,突然出现的偏离车道、追尾、意外刹车等情况,都可能和人工智能系统中的错误代码有关,而且有些错误代码隐藏很深,极难发现和修复。

再者,智能驾驶难以消除“盲区”。

智能驾驶的决策依赖人工智能,而现在的人工智能面临一道巨大障碍:只能解决自身“学习”过的问题,而不能创造性地解决新问题。

人类驾驶者不但能灵活应对各种新场景,就算信息不完整也能根据经验和常识,做出合理推测。

而人工智能虽然可以“深度学习”,却只能对训练过的任务应对自如,没学习过的就属于“异常数据”,一旦遇到就不知所措。

▲智能驾驶在应变方面存在缺陷

比如某品牌汽车曾出现这种意外:智能驾驶可以识别出行驶中的大货车,但前方路面上出现一辆侧翻的大货车时,却毫无察觉,一头撞了上去。

就算智能驾驶学习了99%的常见场景,剩下那1%的罕见场景仍有可能引发车祸,而这种“长尾问题”目前无解。

还有,智能驾驶的“黑盒”暗藏凶险。

人工智能的深度学习模型通常被称为“黑盒”。人类模仿大脑的工作方式设计了模拟神经网络,它可以依靠训练数据去“深度学习”,但没有人真正理解它的决策过程。这就意味着,技术专家不可能预测智能驾驶什么时候会出意外,出了意外,也很难搞清楚是什么原因。

▲人工智能的决策过程是“暗箱操作”

这种情况,也被称为人工智能的“可解释性问题”。

大量案例显示,智能驾驶有可能突然“神经错乱”而引发车祸。最常见的就是莫名其妙的“幽灵刹车”、毫无征兆的“自动加速”和难以预料的“突然转向”。

这些意外什么时候会出现?为什么会出现?——智能驾驶很多肇事原因目前不可解释。

慎用“智能驾驶”

某些汽车厂商热衷于炒作“智能驾驶”,有意无意之间,把一种明显存在缺陷的试验性技术,渲染为成熟可靠的高阶技术。

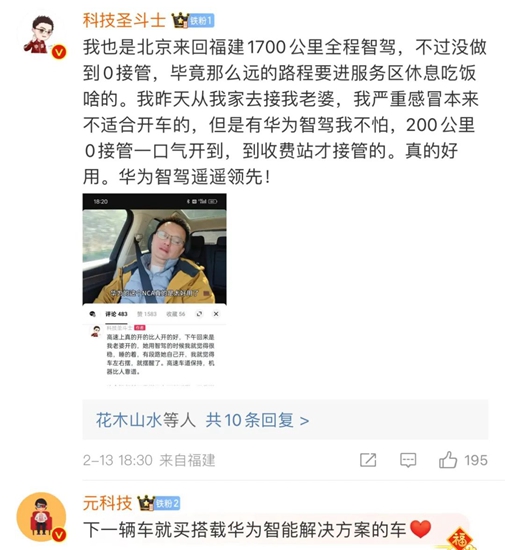

而有些消费者则欣然接受,开车时经常放心使用,甚至产生一定程度的依赖。

▲“智能驾驶”得到不少车主的信赖

更危险的是,有些车主误以为自己的车真的可以在某些路况下“自动驾驶”,当意外出现时,想“接管”已经来不及。

在谈到人工智能参与驾驶时的风险时,玛丽·卡明斯说,大语言模型可能会输出废话,而自动驾驶可能要了你的命。

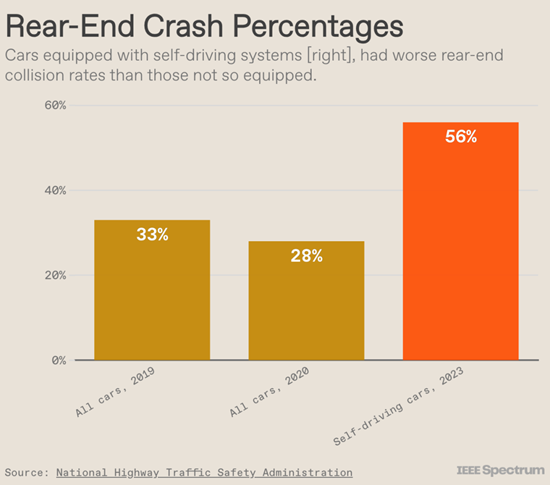

由于先进辅助驾驶功能一年之内就引发数百起车祸,美国公路交通安全管理局已经启动大范围调查,并要求汽车制造商报告相关事故。目前还没有权威数据表明,在相同情况下,使用“智能驾驶”和不使用“智能驾驶”哪个更安全。

▲统计显示,装备自动驾驶系统的车辆追尾事故率高于普通车辆

人工智能科学家、纽约大学心理系教授Gary F. Marcus说:

制造无人驾驶汽车等东西的人就像在玩一个巨大的“打地鼠游戏”,往往刚解决了一个问题,又出现了另一个问题。一个补丁接一个补丁有时能派上用场,有时则无效。

人工智能存在的这些固有缺陷,现在还找不到可靠解决方案。有人寄希望于“通用人工智能(AGI)”,AGI和人类一样可以举一反三,触类旁通,从而能解决机器学习“没见过”的问题——但AGI什么时候能实现,目前未知。

实际上,一些不那么“高阶”的辅助驾驶功能也潜藏风险。作为一名记者和市场监管部门的汽车三包专家,我参与调查处理过的投诉中,一些仅装备基本驾驶辅助功能的汽车也出现意外加速、幽灵刹车、转向失控等问题,涉事车辆价位从十万级别到三十万级别都有。转载自傅雪峰微信公众号

分享:返回慧眼识车其它慧眼识车文章- ·奔驰丰田押注发动机?燃油车要卷土重来?

- ·理想MEGA和丰田新普拉多,设计理念同出一辙

- ·目前“智能驾驶”都不靠谱,技术迷信从何而来?(本文)

- ·插混尽头可能是增程,但不是理想问界这种

- ·大电池触发“基因突变”,比亚迪DM-i为插混改命

上传图片仅支持JPG、GIF、PNG图片文件,且文件小于5M

上传图片仅支持JPG、GIF、PNG图片文件,且文件小于5M

屏蔽用户|只显示该户评论2024-03-11 13:03:50有比没有强,没有智驾的时候,车祸更多[回 复]

屏蔽用户|只显示该户评论2024-03-11 13:03:50有比没有强,没有智驾的时候,车祸更多[回 复]

查看全部评论:

↑顺序

↓倒序

查看全部评论:

↑顺序

↓倒序

- 财金博客

- 理财/管理

- 健康人生

- 时尚艺术

- 吃喝玩乐

- 全部

- 财金博客

- 理财/管理

- 健康人生

- 时尚艺术

- 吃喝玩乐

- 全部

- 运筹帷幄 • 梁业豪014074

- 政政经经 • 石镜泉012563

- 品中资 • 罗国森017106

- 运筹帷幄 • 梁业豪013824

- 政政经经 • 石镜泉019212

- 真知灼见 • 温灼培017601

- 运筹帷幄 • 梁业豪018420

- 谈国论企 • 黎伟成021932

- 慧眼识车 • 傅雪峰130597

- 国际动态033501

- 港是港非 • 李慕飞132277

- 慧眼识车 • 傅雪峰130597

more on Column

more on Column- Features 每日专题

专题

财金博客

陶冬 陶冬天下 李迅雷 李迅雷

陈永陆 陆言堂 黄玮杰 师傅教路

罗国森 品中资 林家亨 股林淘金

胡一帆 全球视野 潘铁珊 投资心得

朱红 权证红盘 郭思治 思前想后

陈其志 牛熊志选 温灼培 真知灼见

梁业豪 运筹帷幄 熊丽萍 缸边丽评

张赛娥 娥姐锦囊 温天纳 融天纳地

黎伟成 谈国论企 邓声兴 投资智慧

姚超文 宝岛热话 魏东 洞析楼市

石镜泉 政政经经 范强 范强 - 理财/管理

【FOCUS】

罗国森 我要退休

李锦 亲子理财

唐德玲 女子爱财

汪敦敬 楼市点评

黄美云 玄来更精彩

Jimmy Leung 改朝换代Digital

Michael & Derek 我做Marketing

管理·创业

沪深港通

国际动态

曾智华 快乐退休

伍礼贤 经济不停学

方展策 智城物语

梁子骢 Brian 销售达人

张少威 威少看世界

张翠容 容我世说

雷鼎鸣 雷鸣天下

李慕飞 港是港非

- 健康人生

健康解“迷”

曾欣欣 欣欣Super Food

陈沛思 食疗新意思

谭莉英 美女中医

Oscar治疗师 都市痛症

李美怡 Cathy Lee 素食厨房

古锦荣 性治疗师手记

云无心 健康朝九晚五

陈涌 健康“肤”识

黎凯欣 照顾者手记 - 吃喝玩乐

食得喜

旅途中

通通 吃一吃

主教练 足球俱乐部

Saii Lee “世”界味觉之旅 - 时尚艺术

妮洛 港女讲男

傅雪峰 慧眼识车

Ivan Lau More Than Fashion

Nadia Tang 时装延想

汝勤 The Dapper Style

Ayu 阿愚 我单身但我快乐

Wayne Hui 寻宝人

编辑爱美丽

费吉 古董投资秘笈

赵健明 Janice Chiu 建筑·艺术·远方

Kogi Ko 寻宝女生日志

一个月内新增栏目北京港经通经济信息咨询服务有限公司上海分公司

一个月内新增栏目北京港经通经济信息咨询服务有限公司上海分公司

经营许可证 : 沪ICP备17049915号-2 沪公网安备 31011502014598

未经许可,不得转载

沪公网安备 31011502014598

未经许可,不得转载

举报邮箱:etnetchina_cs@etnet.com.hk 举报电话:8008200908

中国互联网联合辟谣平台 中国互联网举报中心

免责声明:经济通有限公司及/或第三方信息提供者竭力确保其提供之数据准确可靠,惟不保证该等数据绝对正确。 - 财金博客